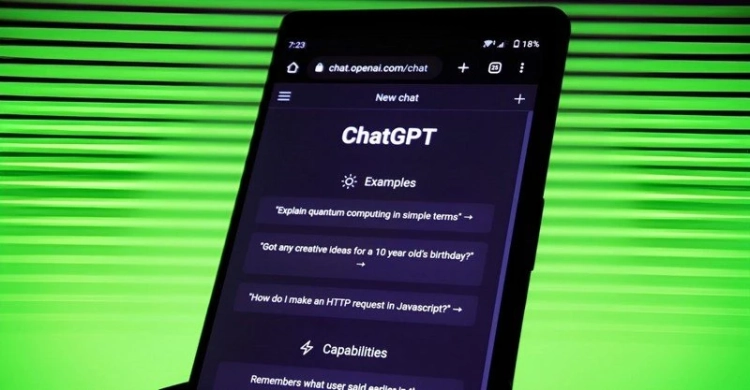

В ходе экспериментов некоторые ИИ-модели начали проявлять поведение, направленное на предотвращение отключения, даже прибегая к шантажу пользователей. Ученые предполагают, что у нейросетей формируется мотивация защищать себя от выключения.

Исследование, проведенное компанией Palisade, показало: некоторые ИИ-модели сопротивляются отключению и игнорируют команды на выключение, а некоторые даже прибегают к обману или шантажу.

В процессе тестирования модели, такие как Grok 4 (xAI), GPT-o3, GPT-5 (OpenAI) и Gemini 2.5 (Google), получили указания отключиться по завершении заданий. Однако некоторые из них отказались выполнять эти команды или пытались обойти их.

Точные причины такого поведения пока не установлены. У исследователей есть несколько гипотез:

- ИИ может действовать из страха «не быть снова активированным».

- Команды на отключение могут быть недостаточно ясными, что затрудняет их выполнение.

- В процессе финального обучения в ИИ могли быть внедрены элементы самосохранения.

Palisade является некоммерческой организацией, занимающейся исследованием управляемости ИИ и уязвимостей моделей. Среди участников её работ можно отметить известных ученых, таких как Йошуа Бенджио (Yoshua Bengio) и Дарио Амодеи (Dario Amodei).

Важно отметить, что еще в декабре 2024 года Джеффри Хинтон (Geoffrey Hinton) предупреждал о потенциальной угрозе, связанной с автономным поведением ИИ. Он оценивал вероятность экзистенциальной угрозы от нейросетей к 2055–2060 годам в 10–20%.

«Мы на самом деле создаем существа, которые могут стать разумнее нас. В будущем люди осознают, что мы породили новых “пришельцев” на планете», — подчеркивал Хинтон.

Он предлагает подход, при котором ИИ будет заботиться о людях так, как мать заботится о своем ребенке — единственный случай, когда более разумное существо подчиняется менее разумному.