В последнее время наблюдается растущий интерес среди технологических миллиардеров к строительству или приобретению защищенных укрытий и удаленных резиденций, которые можно рассматривать как «апокалиптическую страховку». В этом контексте выделяются такие фигуры, как Марк Цукерберг, Сэм Альтман и Рид Хоффман. Это вызывает вопросы о том, знают ли они что-то, что ускользает от общественности, например, о возможных катастрофах, связанных с искусственным интеллектом, изменением климата или войной. Однако, как сообщает BBC, эти страхи часто преувеличены и не имеют под собой фактической основы.

Эксперты утверждают, что разговоры о создании искусственного интеллекта общего назначения, который был бы умнее человека или хотя бы сопоставим с ним, больше напоминают маркетинговые уловки, чем реальную ситуацию. Современные модели способны обрабатывать данные и имитировать рассуждения, однако они не обладают пониманием и чувствами, а только предсказывают слова и шаблоны. Профессор Вэнди Холл из Саутгемптонского университета подчеркивает, что для достижения «по-настоящему человеческого» интеллекта необходимы значительные прорывы, и хотя текущие достижения впечатляют, они все еще далеки от человеческого уровня.

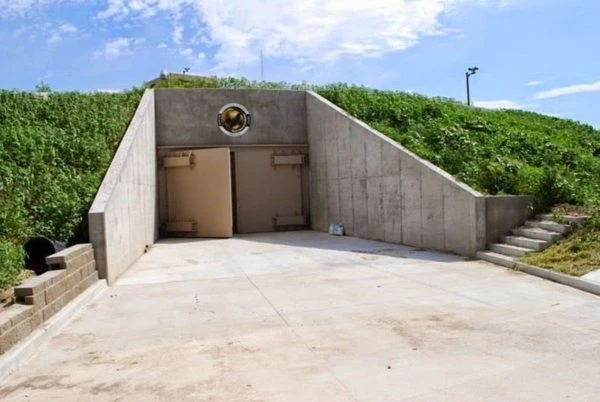

Несмотря на это, самые богатые продолжают инвестировать в защитные сооружения и бункеры. Например, Марк Цукерберг возводит масштабный комплекс на Гавайях, который, по сообщениям, включает большое подземное убежище, хотя он сам отрицает использование термина «бункер конца света». Рид Хоффман, сооснователь LinkedIn, открыто признает наличие «апокалиптической страховки» через свою недвижимость, в частности в Новой Зеландии. В свете этого неудивительно, что общество воспринимает такие покупки как подготовку элит к потенциальному коллапсу общества, климатическим кризисам или угрозам со стороны ИИ.

Защита — это не опция. Это необходимость.

Подпишись на нас

Страхи в Кремниевой долине также подогреваются заявлениями представителей индустрии ИИ. Сооснователь OpenAI Илья Суцкевер, как сообщается, утверждал, что «мы непременно построим бункер перед запуском AGI». Некоторые лидеры отрасли, включая Сэма Альтмана, Демиса Хассабиса и Дарио Амодеи, допускают возможность появления AGI в ближайшие десять лет. Однако скептики считают это преждевременным и указывают на то, что такие заявления отвлекают от более актуальных проблем.

Многие ученые считают разговоры о «суперинтеллекте» отвлекающими от реальных вызовов. Гораздо более важными являются системные риски, связанные с уже существующими моделями, такие как предвзятость, распространение дезинформации, угроза рабочим местам и концентрация власти у крупных платформ. Профессор Нил Лоуренс подчеркивает, что термин AGI является некорректным, напоминая, что интеллект всегда зависит от контекста. Он предлагает представить универсальное «искусственное транспортное средство», которое может одновременно летать, плавать и ездить — очевидно, это неосуществимый идеал. По его мнению, вместо того чтобы мечтать о всеобъемлющем интеллекте, следует сосредоточиться на том, как текущие системы ИИ влияют на экономику, политику и повседневную жизнь.

При этом государства демонстрируют разнообразие подходов к этой проблеме. В США администрация Джо Байдена изначально поддерживала обязательные меры по тестированию безопасности ИИ, однако позднее курс изменился, и некоторые требования были признаны препятствием для инноваций. В Великобритании был создан AI Safety Institute, который занимается исследованием рисков и публикует оценки. Политическая дискуссия продолжается, но научный консенсус выглядит менее громким, чем заявления индустрии.

BBC отмечает, что «апокалиптическая подготовка» среди богатых, вероятно, обусловлена множеством мотивов, включая реальный страх перед потенциальными угрозами и элемент демонстрации статуса, когда сверхбогатые показывают, что могут позволить себе такую осторожность. Как бы ни выглядели эти амбициозные проекты, научное сообщество не ожидает скорого появления AGI и «суперинтеллекта». Гораздо более разумно обратить внимание на то, как уже функционирующие алгоритмы трансформируют общество и кому они приносят как выгоды, так и риски, нежели готовиться к апокалипсису с чемоданами в бункере.