Акыркы убакта технологиялык миллиардерлердин корголгон паналорду куруу же сатып алууга кызыгуусу өсүп жатат, буларды «апокалиптикалык камсыздандыруу» катары караса болот. Бул контекстте Марк Цукерберг, Сэм Альтман жана Рид Хоффман сыяктуу фигуралар белгиленет. Бул алар коомчулукка белгисиз, мисалы, искусственный интеллект, климаттын өзгөрүшү же согуш менен байланышкан мүмкүн болгон кырсыктар жөнүндө кандайдыр бир маалыматка ээ болушу мүмкүн деген суроолорду туудурат. Бирок BBCнин маалыматына ылайык, бул коркуу көп учурда ашыкча жана фактикалык негизден жок.

Эксперттер жалпы максаттагы искусственный интеллектти түзүү жөнүндө сүйлөшүүлөр адамдан акылдуу же эң болбосо ага теңдеш келген, маркетингдик трюкка окшош экенин билдиришет. Заманауи моделдер маалыматтарды иштеп чыгууга жана ой жүгүртүүнү имитациялоого жөндөмдүү, бирок алар түшүнүккө жана сезимдерге ээ эмес, болгону сөздөрдү жана шаблондорду алдын ала айтышат. Саутгемптон университетинин профессору Вэнди Холл «чын эле адамдык» интеллектке жетүү үчүн олуттуу жаңылыктар керек экенин баса белгилейт, учурдагы жетишкендиктер таң калыштуу болсо да, алар адам деңгээлинен алыс.

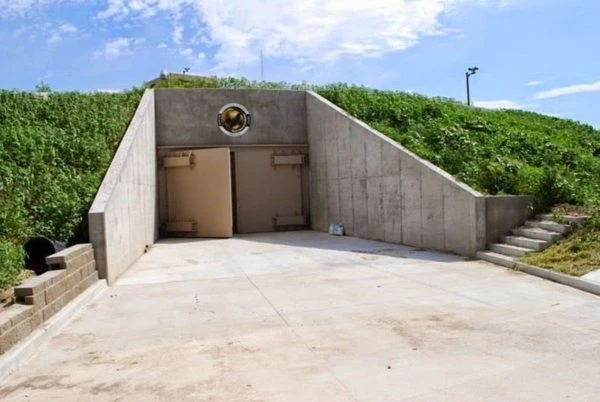

Муну менен бирге, эң бай адамдар коргоочу курулмаларды жана бункерлерди инвестициялоону улантууда. Мисалы, Марк Цукерберг Гавайидеги масштабдуу комплексин куруп жатат, ал чоң жер астындагы паналону камтыйт деп айтылууда, бирок ал «апокалипсис бункери» терминди колдонуу менен макул эмес. LinkedInдин негиздөөчүсү Рид Хоффман өзүнүн мүлкү аркылуу «апокалиптикалык камсыздандыруу» бар экенин ачык мойнуна алат, айрыкча Жаңы Зеландияда. Бул контекстте коомчулук мындай сатып алууларды элиталардын коомдун мүмкүн болгон коллапсына, климаттык кризиске же ИИден келген коркунучтарга даярдыгы катары кабыл алганы таң калыштуу эмес.

Коргоо — бул опция эмес. Бул зарылдык.

Бизге жазылыңыз

Кремний өрөөнүндөгү коркуулар ИИ индустриясынын өкүлдөрүнүн билдирүүлөрү менен да күч алууда. OpenAIнин негиздөөчүсү Илья Суцкевер «AGIни ишке киргизүүдөн мурда бункерди куруу керек» деп айткандыгы жөнүндө маалыматтар бар. Саламаттыкты сактоо жана ИИ тармагынын лидерлери, анын ичинде Сэм Альтман, Демис Хассабис жана Дарио Амодеи, жакынкы он жылда AGIнин пайда болушу мүмкүн экенин билдиришет. Бирок скептиктер бул мезгилден мурда деп эсептешет жана мындай билдирүүлөр актуалдуу маселелерден көңүлдү бурат деп белгилешет.

Көптөгөн илимпоздор «суперинтеллект» жөнүндө сүйлөшүүлөрдү реалдуу чакырыктардан четтетүүчү деп эсептешет. Жана системалык коркунучтар, мисалы, бар болгон моделдер менен байланышкан предвзятостор, дезинформациянын жайылышы, жумуш орундарын коркунучка салуу жана ири платформаларда бийликти топтоо сыяктуу маселелер кыйла маанилүү. Профессор Нил Лоуренс AGI терминин туура эмес деп эсептейт, анткени интеллект ар дайым контекстке жараша болот. Ал бир убакта учуп, сүзүп жана айдап жүрө алган универсалдуу «искусственный транспорт» концепциясын сунуштайт — бул, албетте, мүмкүн эмес идеал. Анын пикири боюнча, бардык камтылган интеллект жөнүндө кыялдануунун ордуна, учурдагы ИИ системаларынын экономикага, саясатка жана күнүмдүк жашоого кандай таасир эткенине көңүл буруу керек.

Муну менен бирге, мамлекеттер бул маселеге ар кандай мамилелерди көрсөтүүдө. АКШда Джо Байдендин администрациясы башында ИИнин коопсуздугун тестирлөө боюнча милдеттүү чараларды колдоп келген, бирок кийинчерээк курс өзгөрүп, кээ бир талаптар инновацияларга тоскоолдук катары таанылды. Улуу Британияда ИИ коопсуздугу боюнча институт түзүлүп, ал коркунучтарды изилдөө менен алектенет жана баа берет. Саясий талкуу уланууда, бирок илимий консенсус индустриянын билдирүүлөрүнөн азыраак угулат.

BBC «апокалиптикалык даярдык» байлар арасында көптөгөн себептерден улам болушу мүмкүн экенин белгилейт, анын ичинде мүмкүн болгон коркунучтарга болгон чыныгы коркуу жана супербай адамдардын мындай сактыкка ээ боло алаарын көрсөтүү элементтери. Бул амбициялуу долбоорлор кандай көрүнгөнүнө карабастан, илимий коомчулук AGI жана «суперинтеллекттин» жакын арада пайда болушун күтпөйт. Кудайдын апокалипсисине даярдануудан көрө, азыркы алгоритмдер коомду кандайча өзгөртүп жатканын жана алар кимдерге пайда жана коркунуч алып келе турганына көңүл буруу кыйла акылдуу.