Согласно исследованию, проведенному ЮНИСЕФ совместно с международной организацией ECPAT и Интерполом в 11 странах, как минимум 1,2 миллиона детей сообщили о том, что их изображения были подделаны с целью создания откровенных фальшивок сексуального характера в прошлом году. В некоторых из исследуемых стран каждый 25-й ребенок стал жертвой такой практики, что соответствует одному ребенку в среднем классе.

Современные дети осознают эти риски: в некоторых странах до двух третей опрошенных заявили о своей обеспокоенности относительно того, что искусственный интеллект может быть использован для создания фальшивых сексуальных изображений или видео. Уровень беспокойства варьируется в разных странах, что подчеркивает необходимость повышения осведомленности и усиления мер по профилактике и защите.

Важно отметить, что сексуализированные изображения детей, созданные или обработанные с использованием ИИ, относятся к материалам, связанным с сексуальным насилием (CSAM). Злоупотребление дипфейками является серьезной проблемой, которая наносит реальный вред.

Когда используется изображение ребенка, он становится непосредственной жертвой. Даже в тех случаях, когда идентифицируемых жертв нет, такие материалы способствуют нормализации сексуальной эксплуатации детей, создают спрос на контент с насилием и усложняют работу правоохранительных органов по выявлению и защите нуждающихся в помощи детей.

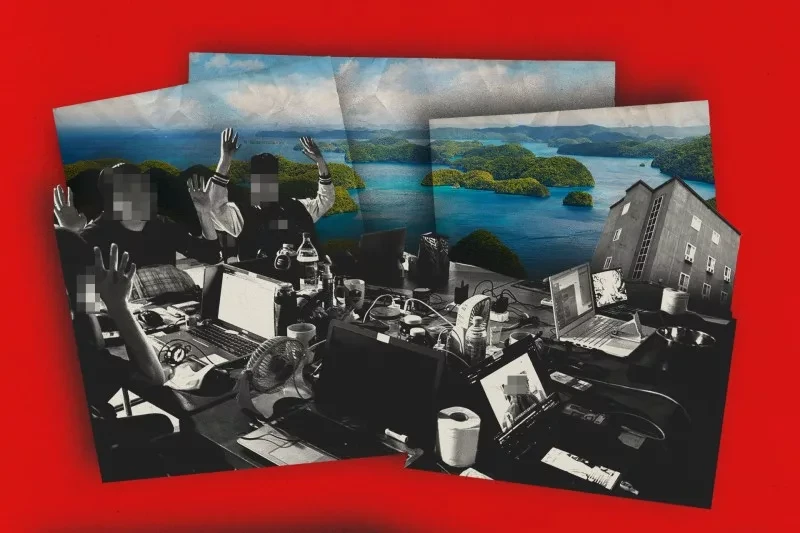

ЮНИСЕФ поддерживает усилия разработчиков ИИ, которые внедряют безопасные подходы и надежные меры защиты для предотвращения неправомерного использования своих технологий. Однако на данный момент ситуация остается неоднородной, и многие модели ИИ разрабатываются без должных гарантий. Риски увеличиваются, особенно когда инструменты генеративного искусственного интеллекта интегрируются в социальные сети, что приводит к быстрому распространению обработанных изображений.

К числу мер, которые ЮНИСЕФ настоятельно призывает принять для борьбы с растущей угрозой материалов о сексуальном насилии над детьми, созданных с помощью ИИ, относятся следующие:

- Расширение определения материалов о сексуальном насилии над детьми (CSAM) для включения контента, созданного искусственным интеллектом, и криминализация его создания, хранения и распространения.

- Разработчики ИИ должны внедрять безопасные подходы на этапе разработки и обеспечивать надежные меры защиты для предотвращения их неправомерного использования.

- Цифровые компании обязаны предотвращать распространение материалов с изображением сексуального насилия над детьми, созданных с помощью ИИ, и усиливать модерацию контента, инвестируя в технологии обнаружения, чтобы такие материалы можно было удалять немедленно, а не через несколько дней после обращения жертвы или ее представителя.

Проблема злоупотребления дипфейками требует срочных действий. Дети не могут позволить себе ждать, пока законы вступят в силу.